门捷列夫曾经说过:“科学是从测量开始的”。光学成像拓展了人类的认知边界,推动了科学的进步,诸如显微镜,望远镜等;同时也应用于人们生活的方方面面。然而受到不可避免的镜面加工误差,系统设计缺陷与环境扰动的限制,使得实际成像分辨率与信噪比往往显著低于完美成像系统。光学像差,即是对光学系统不完美程度的定量描述。如何实现无像差的完美光学成像一直是光学中最重要且仍悬而未决的难题之一。《科学》杂志也将“能否制造完美的光学透镜”列入21世纪125个科学前沿问题。

近日,清华大学成像与智能技术实验室提出了一种集成化的元成像芯片架构(Meta-imaging sensor),为解决这一百年科学难题开辟出新路径。

区别于构建完美透镜,该团队研制出一种超级传感器,可以记录成像过程而非图像本身,通过实现对非相干复杂光场的超精细感知与融合,即使经过不完美的光学系统与复杂的成像环境,依然能够实现完美的三维光学成像。

研究人员表示:“该技术有望实现于大部分像感器架构,无需改变现有的光学成像系统,带来颠覆性的变化,将用于天文观测,医疗诊断,生物成像,工业检测,移动终端,安防监控等具有高精度探测需求的复杂场景。”

日前,相关论文以《集成化成像芯片实现像差矫正三维摄影》(An integrated imaging sensor for aberration-corrected 3D photography)为题发表在Nature上[1]。

图1.相关论文

戴琼海院士、方璐副教授为共同通讯作者;吴嘉敏助理教授、博士生郭钰铎、博士后邓超担任共同一作;乔晖助理教授、以及张安科、卢志、谢佳辰三位博士生为共同参与者。

如何破除完美成像的“拦路虎”光学像差?

据介绍,传统光学系统主要为人眼所设计,保持着“所见即所得”的设计理念,聚焦于在光学端实现完美成像。

近百年来,光学科学家与工程师不断提出新的光学设计方法,以给不同成像系统定制复杂的多级镜面、非球面与自由曲面镜头,从而通过减小像差来提升成像性能。

但是,由于加工工艺的限制与复杂环境的扰动,难以制造出完美的成像系统。例如,鉴于大范围面形平整度的加工误差,人们依旧难以制造超大口径的镜片去实现超远距离高分辨率成像;而受到动态变化的大气湍流扰动,地基天文望远镜的实际成像分辨率远低于光学衍射极限,这限制了人类探索宇宙的能力,往往需要花费昂贵的代价发射太空望远镜绕过大气层。

为解决这一难题,自适应光学技术应运而生。通过波前传感器,可以实时感知环境的像差扰动,并反馈给一面可变形的反射镜阵列,借此给对应的光学像差做出动态矫正,从而保持完美的成像过程。

基于此,有学者发现了星系中心的巨大黑洞并斩获诺奖,这一成果也已用于天文学与生命科学领域。然而,由于像差在空间分布的非均一特性,该技术仅能实现极小视场的高分辨成像,难以实现大视场多区域的同时矫正。而且,由于需要非常精细的复杂系统,导致成本往往十分高昂。

图2.左,波前传感器;右,可变形镜

图2.左,波前传感器;右,可变形镜

近年来,数字化的高速发展催生了计算光学这一交叉学科,为先进成像系统设计提供了新的思路。

而该团队长期从事这一领域,在三维成像、超光谱成像、极弱光成像、介观活体显微成像、超分辨率显微等方向已取得系列突破。

为了实现从完美透镜到完美成像的转变,受自然界中“涌现”现象的启发,课题组提出了元成像的新架构,攻克了超精细光场感知与超精细光场融合两大核心技术。

详细来说,其以分布式感知突破空间带宽积瓶颈,以自组织融合实现了多维、多尺度、高分辨的重建,借此能够在后处理过程中通过对光线的数字调制替代了光学系统中的物理模拟调制,并将其精度提升至光学衍射极限,为解决光学像差这一百年难题打开了新局面。

图3.从左至右:普通成像芯片、传统光场成像、元成像芯片(无DAO),元成像芯片(DAO)结果对比

将所有技术集成在单个成像芯片上,可广泛用于几乎所有成像场景

为何说打破了新局面?这得从1908年说起,当年诺贝尔物理学奖得主加布里埃尔·李普曼(Gabriel Lippmann)首次提出模拟昆虫复眼的光场成像技术(又称集成成像),使用透镜阵列获取场景的多角度信息实现三维感知。

后来,斯坦福大学计算机图形学教授马克·勒沃伊(Marc Levoy)极大推动了基于微透镜阵列的光场成像,在计算机视觉与图形学领域的应用。

通过同时感知场景的四维空间-角度信息,光场技术为计算摄像提供了可能性,能够在后处理过程中实现复杂的图像渲染、视频合成、三维重构等,并在三维视觉、显微成像、工业检测等领域显示出了巨大潜力,诞生了Lytro、Raytrix等著名公司。

然而,从根本上,传统光场成像受到海森堡不确定性原理的限制,存在着空间分辨率与角度分辨率间的固有矛盾。当对空间定位非常精确的时候,就损失了对角动量的定位精度。

为了获得不同角度的信息,则不可避免地要对孔径进行分割,因此会降低每一子孔径图像的空间分辨率,导致以往光场成像的精度远低于传统成像,进而限制了相关应用。因此,如何实现超精细的非相干光场感知,是这一领域的核心难点。

2021年受到昆虫复眼在光刺激时会产生高频振荡这一光致机械响应机制的启发,该团队提出了扫描光场成像原理[2],通过引入时-空-角耦合采样,绕过了海森堡不确定性的限制,在部分相干光下获取到了接近衍射极限的空间信息与角度信息,实现了光场的超精细感知。

进一步地,如何将不同角度对应的“子孔径”信息有效融合起来仍然是一个问题。期间,研究人员想到了曾于1974年获得诺贝尔物理学奖的相干孔径合成技术,其通过同时感知复数场的幅度与角度信息,能实现不同子孔径的合成,目前已广泛应用于遥感、雷达与天文观测中。

然而,对于日常生活中最常见的非相干光而言,传统光电探测器仅能获得强度信息而缺乏相位信息,如何实现有效的孔径融合,从而将不同角度信息转换为空间分辨率,仍然是一个悬而未决的问题。

图4.元成像芯片架构与原理样机

为解决这一问题,课题组充分利用了极小尺寸微透镜所带来的衍射效应,在每一个微透镜上加上了一层衍射编码,就像结构光成像一样,先将高频信息混叠在低频上再进行孔径分割,借此避免了空间分辨率的损失。

这就相当于为非相干光场添加了额外的相干性,如同积木间的榫卯结构一样层层相扣,再结合相空间迭代算法,即可实现同一镜头下的非相干光孔径合成,进而将光场融合的空间分辨率提升到衍射极限。

而在此次成果里,戴琼海团队将所有技术集成在单个成像芯片上,使之能广泛应用于几乎所有的成像场景,而不需要对现有成像系统做额外的改造。

单镜片十亿像素成像,天文观测湍流像差矫正视场直径从40角秒提升至1000角秒

事实上,元成像芯片、与传统成像芯片或者光场相机的最大区别,在于前者实现了对于复杂光场的高维超精细感知与融合,在波动光学的尺度上完整记录了整个成像过程、而非图像本身,在具备极大的灵活性的同时,又能保持前所未有的成像精度。

这一优势带来的好处是:在数字端针对复杂光场进行操控时,可以完全媲美物理世界的模拟调制,就好像人们真正地在数字世界搬移每一条光线一样。

基于此,该团队建立了数字自适应光学架构,通过多角度信息实现了大视场多区域的快速像差估计,在非相干孔径合成的过程中,根据估计出来的像差,对所有光线进行重新搬移,进而实现完美聚焦。

不同于传统自适应光学技术仅能矫正一个小区域内的像差,数字自适应光学将感知与矫正的过程解耦开来,能同时实现不同区域的像差矫正。

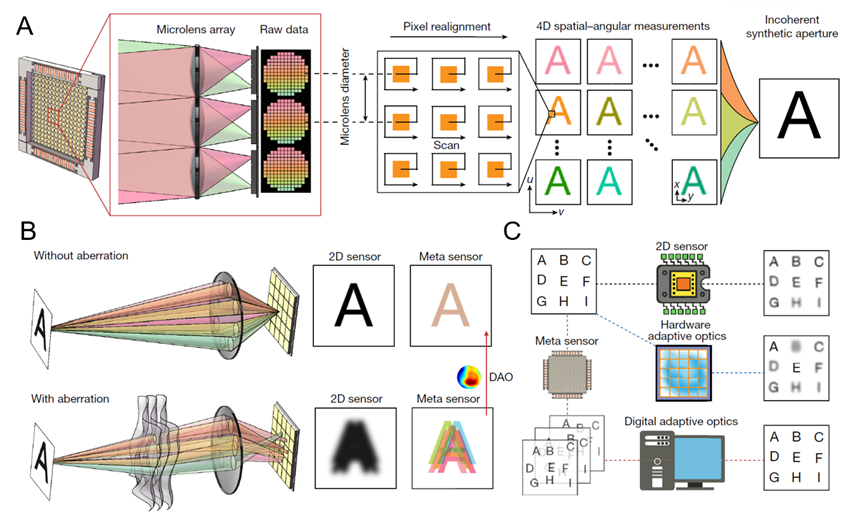

图5.A.元芯片成像原理;B. 普通传感器与元成像芯片的像差成像模型;C. 硬件自适应光学与数字自适应光学(DAO)的对比,DAO可以实现全局不一致的大视场像差矫正。

图5.A.元芯片成像原理;B. 普通传感器与元成像芯片的像差成像模型;C. 硬件自适应光学与数字自适应光学(DAO)的对比,DAO可以实现全局不一致的大视场像差矫正。

据该课题组介绍,元芯片的数字自适应光学能力有望带来成像系统的根本性改变。传统相机镜头的成本和尺寸,都会随着有效像素数的增加而迅速增长,这也是为何高分辨率手机成像镜头即便使用复杂工艺也很难变薄、以及高端单反镜头特别昂贵的原因。

因为它们通常需要借助多个精密设计的多级镜片,来校正空间不一致的光学像差。而如果想推进到有效的一亿像素成像,对于传统光学设计来说几乎是一场“灾难”。

幸运的是,数字自适应光学技术的出现,让人们能使用非常简易的光学系统实现高性能成像。研究人员表示:“利用元成像芯片,我们使用单片三维打印的塑料镜片,就能达到红圈单反镜头的成像性能,并能显著提升有效成像景深,甚至仅仅使用单个镜片就能实现十亿像素级别的宽视场高分辨率成像,而这在之前往往需要复杂庞大的成像系统。”

图6.单镜片十亿像素成像 A.普通成像芯片结果;B. 元成像芯片结果;C-F.两种芯片的成像结果局部放大对比。

除了成像系统存在的系统像差以外,成像环境中的扰动也会导致空间折射率的非均匀分布,从而引起复杂多变的环境像差。

其中最为典型的是大气湍流对地基天文望远镜的影响,这从根本上限制了人类地基的光学观测分辨率,迫使人们不得不花费高昂的代价发射太空望远镜,比如价值百亿美元的韦伯望远镜。

硬件自适应光学技术,虽然可以缓解这一问题,但是它设计复杂、成本高昂,并且有效视野直径通常都小于40角秒。

而借助数字自适应光学技术,只需将传统成像传感器替换为元成像芯片,就能为大口径地基天文望远镜提供了全视场动态像差矫正的能力。

为了验证其有效性,在中国国家天文台兴隆观测站上的清华-NAOC 80厘米口径望远镜上,该团队将元成像芯片与传统成像芯片,进行了地月40万公里观测的实验对比。

结果显示,数字自适应光学方法能够实现1000角秒直径范围内的多区域动态像差矫正,显著提升了成像分辨率与信噪比,有望实现下一代高通量高分辨率地基光学巡天。

图7.基于80cm口径望远镜的40万公里地月观测实验,动态多区域湍流像差矫正。

除了能实现复杂环境下、宽视场高分辨率大景深范围成像以外,元成像芯片还可同时获取高密度高分辨率的深度信息,在横向和轴向上都具有远高于传统光场相机的定位精度,可给自动驾驶与工业检测等场景,提供一种低成本、被动式、高通量的解决方案。

图8.清华大学艺术博物馆三维重建结果对比。B.传统光场成像与元成像结果对比,在相同算法下元成像具有更高的定位精度。C.传统光场成像与元成像结果在空域、EPI域的局部放大对比;D.传统光场成像、元成像芯片三维重建的局部放大对比。

而在未来,课题组将进一步深入研究元成像架构,充分发挥元成像在不同领域的优越性,有望研发新一代通用像感器架构,从而带来三维感知性能的颠覆性提升,或可广泛用于天文观测、工业检测、移动设备、自动驾驶、安全监控、医疗诊断等。研究人员最后表示:“相关工作同步已经在元潼(北京)技术有限公司进行产业转化。”

参考资料:

1.Wu, J., Guo, Y., Deng C., et al. An integrated imaging sensor for aberration-corrected 3D photography. Nature (2022). https://www.nature.com/articles/s41586-022-05306-8

2.Wu, J., Lu, Z., Jiang, D., et al. Iterative tomography with digital adaptive optics permits hour-long intravital observation of 3D subcellular dynamics at millisecond scale. Cell, 184(12): 3318-3332 (2021). https://doi.org/10.1016/j.cell.2021.04.029