复杂的生物过程在细胞、组织的三维空间中时刻维持着精密有序的运转,维系生命活动的基本功能。为了以三维视角观测动态生物过程,诺贝尔化学奖得主Eric Betzig发明了晶格光片显微镜(LLSM),相较传统宽场或共聚焦显微镜,显著降低了活体样本的光漂白和光毒性。晶格光片结构光照明显微镜(LLS-SIM)将LLSM与结构光照明(SIM)结合,在分辨率、成像速度与时程之间实现了理想平衡。然而,传统LLS-SIM采用单方向照明,导致空间分辨率各向异性,未超分辨方向易产生畸变,限制了对三维亚细胞动态的精准探测。近年来,以深度学习为代表的智能计算方法对光学显微镜发展产生变革性影响。通过光学成像系统与智能算法的联合优化,可在极大程度上突破光学系统设计的时空带宽固有局限,实现超高速、超分辨、超长时程活体荧光显微成像。如何突破现有观测工具的性能瓶颈,以三维视角和亚细胞级分辨率观测动态生物过程,是研究复杂生命过程的重要需求。

2025年4月29日,清华大学自动化系戴琼海团队与生命学院李栋课题组合作在Nature Methods杂志上发表题为“Fast-adaptive super-resolution lattice light-sheet microscopy for rapid, long-term, near-isotropic subcellular imaging”的研究论文。该研究提出元学习驱动的反射式晶格光片虚拟结构光照明显微镜(Meta-rLLS-VSIM)及相应的各向同性超分辨重建框架,通过虚拟结构光照明、镜面增强双视角探测、Bayesian双视角融合重建等技术创新,在不牺牲成像速度、光子代价等核心成像指标的前提下,将LLS-SIM 的一维超分辨能力扩展至XYZ三个维度,实现横向 120 nm、轴向 160 nm 的近各向同性成像分辨率。特别地,该工作将元学习策略与系统数据采集过程深度融合,仅需3分钟就可以完成从训练数据采集到深度学习模型的自适应部署过程,让AI工具在实际生物实验中的应用达到近乎“零门槛”。合作团队在植物花粉管、小鼠胚胎、秀丽隐杆线虫胚胎及有丝分裂或分裂间期的其他真核生物等多种标本上进行了实验,验证了 Meta-LLS-VSIM 在快速、长时程、多色三维超分辨成像任务中的成像能力。

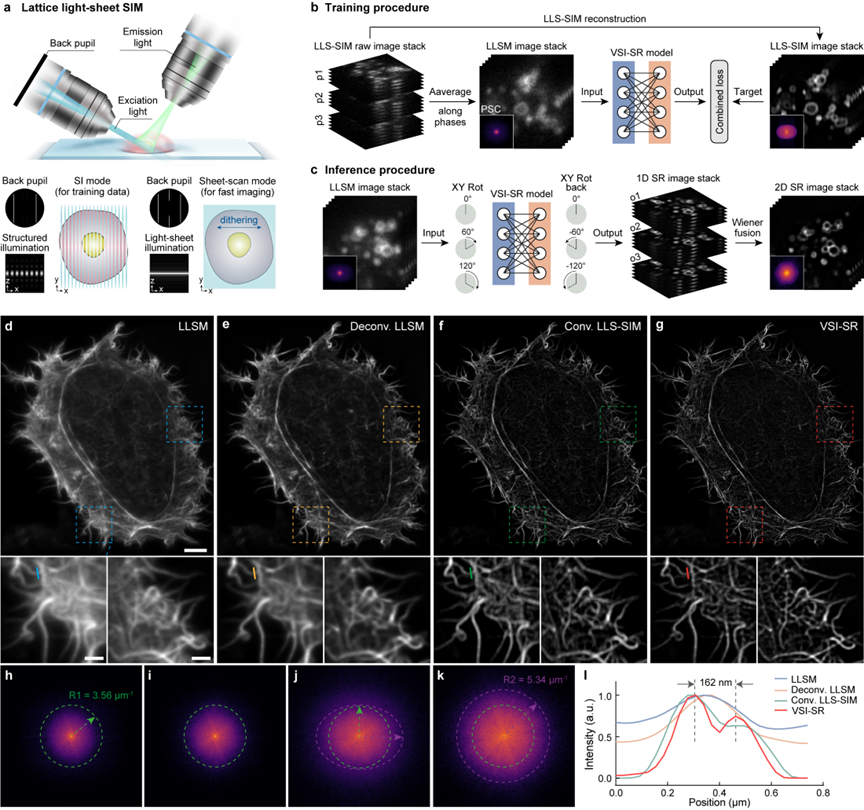

虚拟结构光照明实现横向各向同性超分辨重建

LLS-SIM通过两束光干涉在单一方向产生结构光片照明图案(图1a),从而提升单一维度空间分辨率。但受限于激发物镜光轴取向,其产生的结构光图案无法像标准SIM一样旋转,导致空间分辨率各向异性。针对此问题,合作团队提出一种虚拟结构光照明方案,即首先利用 LLS-SIM 结构光照明模式采集高低分辨率数据对,训练用于一维超分辨推理的深度神经网络(DNN)模型(图1b),再应用训练好的 DNN生成其他方向的各向异性一维超分辨图像。最后类似标准 SIM 重建,将不同取向的多个一维超分辨图像通过广义维纳滤波进行解卷积重建,获得横向各向同性超分辨体栈(图1c)。图1d-l展示了不同方法对于肌动蛋白微丝的成像效果对比图,验证了所提出虚拟结构光照明成像在空域和频域上的显著分辨率提升效果。

图1 虚拟结构光照明二维各向同性超分辨成像方法示意与效果展示

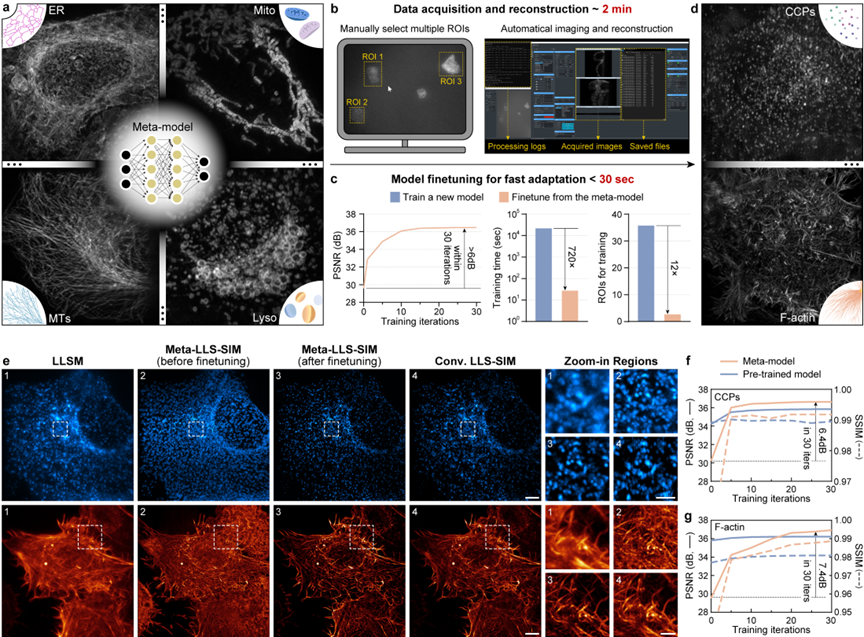

元学习驱动的模型快速自适应部署

由于亚细胞生物结构的形态多样性和DNN表征能力有限,当前深度学习超分辨方法通常需为每种特定生物结构训练专用模型以实现最佳推理效果,而每次模型训练需成百上千对高质量数据,耗时数小时至数天,难以广泛用于日常对于多种生物样本的成像实验中。为此,合作团队提出了一种元学习解决方案,即将不同生物样本和信噪比的超分辨重建问题视为单独的子任务,首先通过现有数据训练一个通用元模型。不同于传统有监督学习或预训练模型,通用元模型旨在学习不同子任务的共性需求,在参数空间寻找可快速迁移至不同任务的收敛点,最终在实际应用中仅需少量数据集和梯度更新即可快速迁移到适配新任务的模型参数(图2a-d)。

图2 元学习驱动的模型快速自适应部署实现流程及效果展示

为了充分发挥元模型的性能,研究团队通过简化自动数据采集、数据预处理和元微调流程,为所搭建的LLS-SIM系统赋予了元学习驱动的快速自适应部署能力。在实际应用中,用户仅需在控制软件窗口中选择3个细胞区域,后续数据采集和所有计算流程(包括LLS-SIM重建、数据增强和元微调)将全部由系统自动执行。整个数据采集过程大约为2分钟,而模型微调过程(重建图像峰值信噪比提升6dB以上)使用单张显卡仅需30秒以内,所需数据量比标准有监督学习减少12倍,速度快720倍(如图2c所示)。

合作团队使用网格蛋白小窝(CCP)和肌动蛋白微丝(F-actin)两种新结构对元模型微调效果进行评估(如图2e、f所示),发现初始元模型仅需一次微调迭代就可去除大部分伪影,损失函数在30次迭代内即可完成收敛,大幅提升对于两种结构的超分辨重建能力。结合虚拟结构光照明,所提出方法可消除各向异性LLS-SIM图像的重建伪影,清晰地分辨CCP分布位置与F-actin密集交织的结构细节。

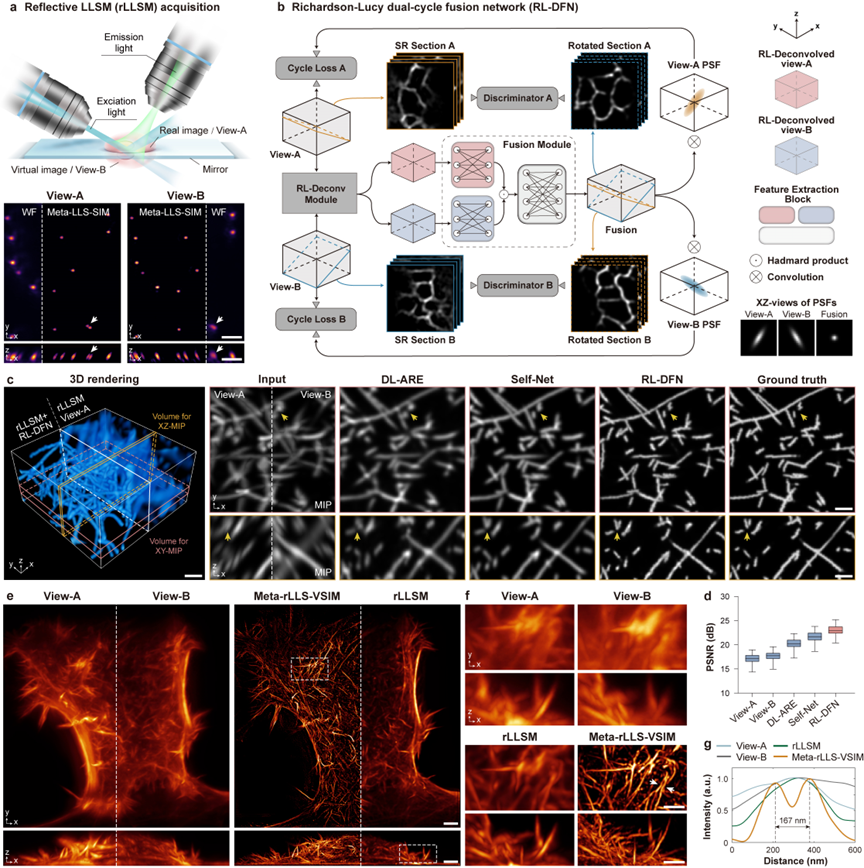

Meta-rLLS-VSIM实现近各向同性超分辨成像

虚拟结构光照明可有效将一维超分辨能力扩展至二维平面,但无法提升轴向分辨率。近年,若干基于深度学习的方法通过自学习(Self-learning)或循环生成对抗网络(Cycle-GAN)在无真值条件下通过数据驱动的方法直接提升轴向分辨率。但通常轴向分辨率比横向差三倍以上,导致这些方法存在严重欠定性,难以保证重建正确性。

图3 Meta-rLLS-VSIM重建原理及效果展示图

为更合理地提升Meta-LLS-VSIM的轴向分辨率,合作团队采用镜面增强双视角探测方案同时获得分辨率互补的两个视角信息(图3a),并设计融合算法——Richardson-Lucy双循环融合网络(RL-DFN),将多视角RL迭代和系统点扩散函数(PSF)先验融入神经网络架构和损失函数设计(图 3b)。双视角信息的有效融合从物理本质上使轴向分辨率提升更为合理,相比于其他数据驱动算法,RL-DFN能够以各向同性分辨率更精确地恢复出样本细节(图 3c、d)。

集成以上技术创新,合作团队构建了完整三维各向同性重建框架,包括荧光背景抑制、图像体栈去倾斜、横向各向同性重建、双视角分离与配准,以及RL-DFN双视图融合,最终实现横向120nm分辨率、轴向160nm的近各向同性成像分辨率(图3e-g),体积分辨率相比传统LLSM提升15.4倍(横向2.3倍、轴向2.9倍)。

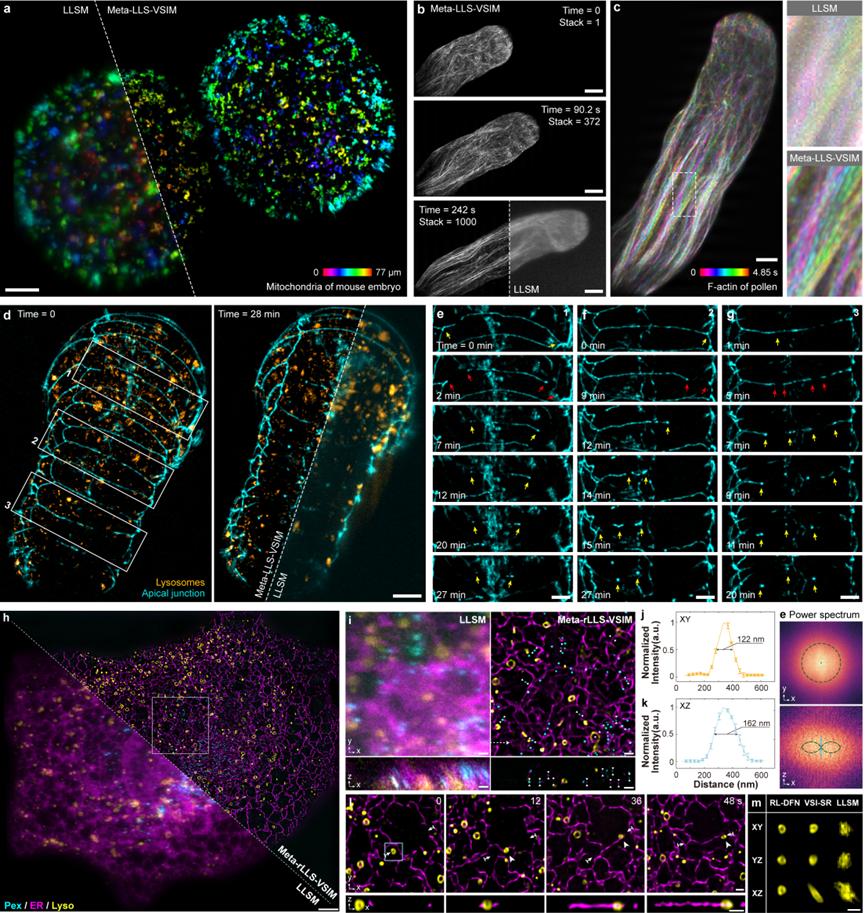

Meta-rLLS-VSIM实现快速五维超分辨活细胞成像

为展示Meta-rLLS-VSIM的快速五维(波长通道-XYZ三维空间-时间)超分辨活细胞成像能力,合作团队对小鼠胚胎(图4a)、植物花粉管(图4b、c)、线虫胚胎(图4d-g)等大体积厚样本进行了长时程超分辨观测。兼具晶格光片照明的物理光学层析与近各向同性的三维超分辨能力,Meta-rLLS-VSIM清晰地揭示了花粉管顶端极性生长、秀丽隐杆线虫胚胎发育过程中质膜融合等生物过程。

图4 Meta-rLLS-VSIM实现快速五维超分辨活细胞成像效果展示

进一步地,合作团队利用Meta-rLLS-VSIM对完整COS-7细胞进行了快速(每8秒拍摄一组三通道完整细胞数据)、长时程(>800个时间点)、近各向同性超分辨成像(图4h-m),对不同细胞器在三维空间中的分布模式及其与细胞骨架的时空协同互作机制进行了精确的定量研究。得益于高时空分辨率与长周期的观测窗口,合作团队观测到微管与溶酶体之间“搭便车”、线粒体在溶酶体运动产生的机械力作用下分裂等新现象,验证了Meta-rLLS-VSIM发现新生物现象与机制的潜力。

综上所述,Meta-rLLS-VSIM通过反射增强双视角晶格光片显微镜与元学习快速自适应部署模式的成像系统硬件升级,与虚拟结构光照明和RL双循环融合网络的人工智能算法创新,展现了软硬件协同优化带来的成像性能巨大提升。Meta-rLLS-VSIM的出现为细胞生物学、神经科学等基础学科发展提供了新的技术路径,有望帮助生命科学研究人员从更全面的多维视角发现、理解、探究丰富多彩的生物现象。

清华大学自动化系博士后乔畅、复旦大学副研究员李子薇、中科院生物物理所博士后王宗发、博士生林煜桓、瑞士洛桑联邦理工学院博士后刘冲为该论文共同第一作者。清华大学生命科学院李栋教授、自动化系戴琼海院士为该论文共同通讯作者。